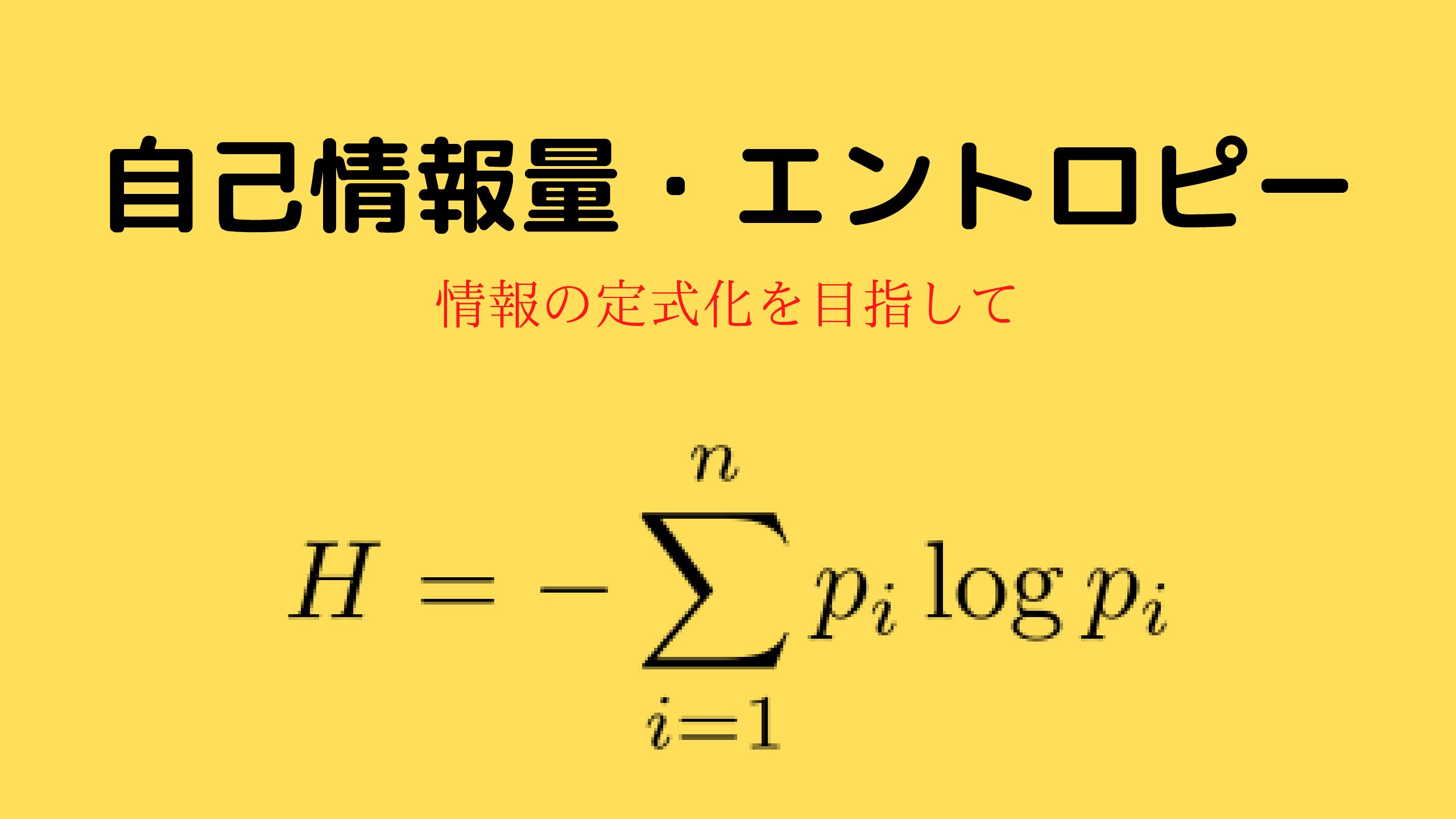

情報エントロピーと自己情報量を初学者でもわかるように説明してみた

- 自己情報量・情報エントロピーってなんだ?

- 情報量って数式で表現できるの?

- 自己情報量・情報エントロピーを理解したつもりになっているかも…

その疑問を解決していきます。

この記事では、自己情報量と情報エントロピーの意味が理解できるように、具体例を使って解説していきます。

特に情報理論の本を読んで挫折してしまった方は、この記事を一度読んでみてください。

可能なら解説記事を書きます!!

*(iphone・Androidの方へ)数式はスクロール可能です。

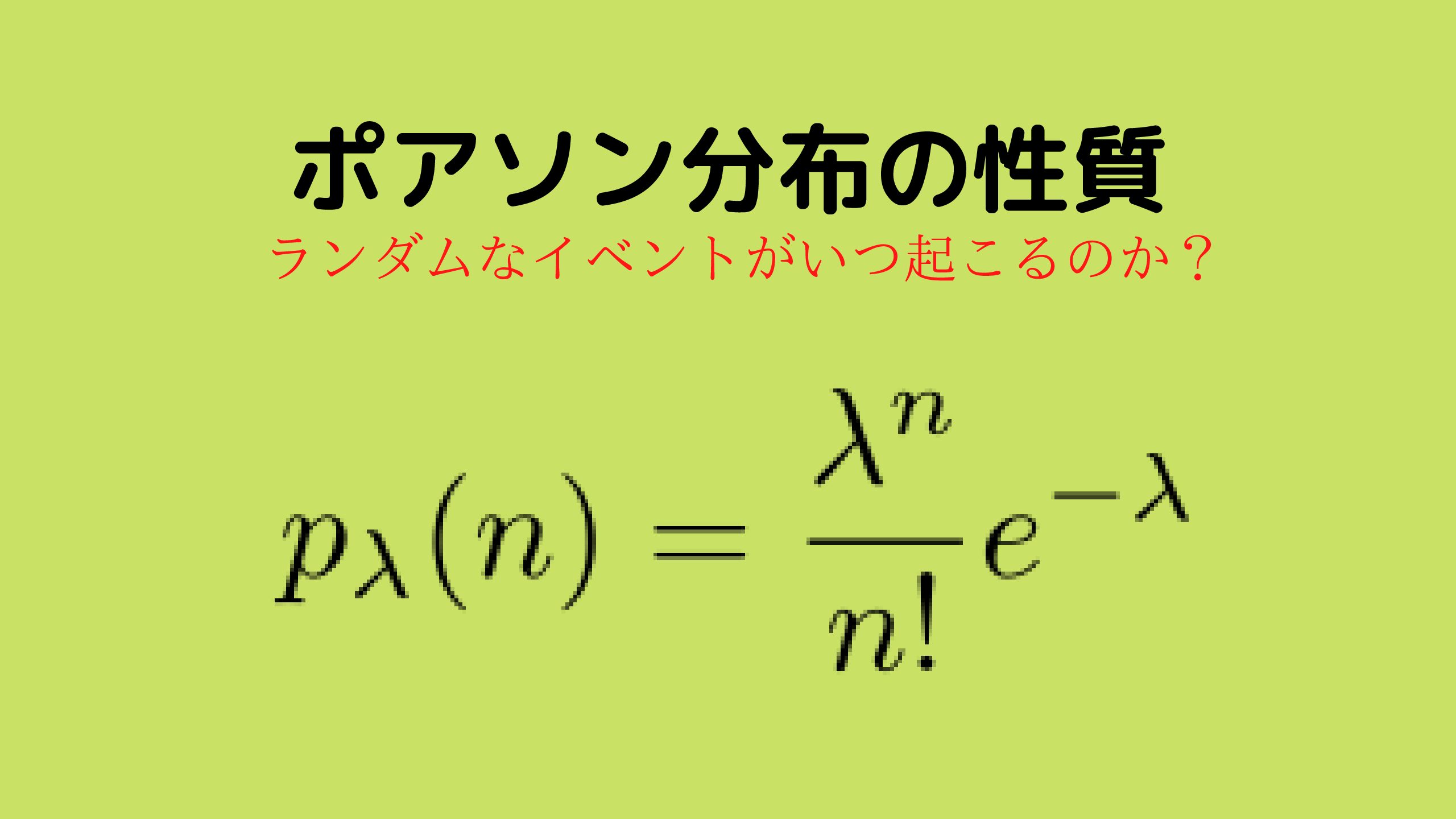

自己情報量【情報量を数式で表したい】

ネタバレになりますが(自己)情報量は以下の形で定式化することができます。

$$ i(x) =~ – \log_{2}(P(x)) $$

実は、この定式化は情報量としての以下の2つの要請を満たしているのです。

- 確率が小さい時の方が情報量は大きい

- 情報は足し合わせできる

簡単に確認してみましょう。

確率が小さい時の方が情報量は大きい

適当に情報量を決めても決まるはずはないので、情報量を定式化するために2つの要請を考えました。

1つの目の要請は、『確率が小さい時の方が情報量が大きい』ことです。

実は、情報量としてかなり自然な要請です。

例えば、「人間が言葉を話す」ことは普通ですが「チンパンジーが言葉を話す」という事象は情報量が一気に増えますよね。

すなわち、確率が低い(チンパンジーが言葉を話す)方が情報量は大きくなるのです。

そして、\(i(x) =~ – \log_{2}(P(x))\)は確率が小さければ大きくなる量になっています。

情報は足し合わせできる

情報は足し合わせできるというのが2つ目の要請です。

情報は積み重なって徐々に大きくなるので、情報を足し合わせることができるというのも自然な要請ですよね(情報の加法性)

実は、上記で定義した情報量は情報の加法性を満たしています。

情報量の加法性(具体例)

情報エントロピー【わからなさを数式で表したい】

今までは、ある事柄が起こった時に得られる情報量を定式化してきました。

次のステップとして、ある事柄が起こったことを教えてもらう時に、どのくらい価値がある情報なのかを定式化することを考えます。

またネタバレになりますが、ある事柄が起こったことを教えてもらう時の価値を表す量は以下のように定式化されます。

$$ H(X) = ~- \sum_{i} P(x_{i}) \log_{2} P(x_{i}) $$

この定式化は以下のような要請によって定式化されました。

知っていることが少ない人ほど得られる情報の価値は大きくなる。

以下詳しく説明していきます。

情報が少ないほど得られる情報の価値は大きくなる要請

ある事柄が起こったことを教えてもらう時、自分が知っている情報が少ない時ほど価値のある情報に感じますよね。

具体例として、サイコロ当てゲームを使って説明していきます。

ゲームの内容は簡単で私がサイコロを振って、その出た目を当てたら500円もらえるゲームです。

ここで、私は「賞金を200円下げる代わりに出た目が奇数か偶数か教えてあげよう」と言い出します。

そのとき、5と6が出ていないことを知っているAさんと、全くなにが出たかわからないBさんがいた場合どちらがその情報を欲しがると思いますか?

全く何も知らないBさんは当たる確率が1/6なので、賞金が下がっても良い覚悟で情報を教えてもらいますよね。

一方Aさんは、当てる確率が1/4なので少しためらうはずです。

なので、情報が少ないほと価値のある情報になっているという要請は自然な要請なのです。

情報エントロピーの妥当性

先ほどのサイコロ当てゲームでわかったことは、自分自身が持っている情報が少ない場合相手から与えられる情報の価値は上がるという結論ですね。

では、ネタバレをしてしまった\(H(X) =~ – \sum_{i} P(x_{i}) \log_{2} P(x_{i})\)とう量がその価値を表す定式化になってるか確認しましょう。

では、まずAさんの場合について情報エントロピーを計算してみます。

Aさんは出る目が5、6以外を知っているので、それ以外の目は1/4の等確率で現れます。

ゆえに情報エントロピーは以下のように計算できます。

Bさんは、出る目の情報を全く知らないので、1/6の等確率で現れます。

$$ H(X) =~ – \frac{1}{6} \left( \log_{2}{\frac{1}{6}} \times 6 \right) \simeq 2.585 $$

予想どうり、Bさんの方が情報エントロピーは大きくなりました。

この結果から、情報エントロピーは情報数が少ない時ほど価値のある情報を定式化していることがわかりました。

情報エントロピーはわからなさを表している

解釈の問題ですが、情報エントロピーはわからなさを表しています。

理由は、情報が少ないとき(よくわからない状態)に価値のある情報かどうかを判断する量で、わからない時ほど情報エントロピーが大きくなるなら

情報エントロピー = わからなさ

と考えても良いことになります。

解釈の問題ですが、情報エントロピーはわからなさを表していると認識しておくと便利な場面が多いです。

情報エントロピーの性質

情報エントロピーは以下の2つの性質を持ちます。

- 情報エントロピーは負にならない

- 情報エントロピーの最大値は全てが等確率に起きる時

情報エントロピーは負にならない

情報エントロピーは非負の量で以下のような不等式が成りたちます。

$$ H(X) \geq 0 $$

証明

\( 1 \geq p(x_{i}) \geq 0 \)なので以下の不等式が成り立ちます。

$$ – p(x_{i}) \log{p(x_{i})} \geq 0 $$

ゆえに

$$ H(X) \geq 0 $$

等号が成立する時は、\( p(x_{i}) = 0 \)または\( p(x_{i}) = 1 \)の時です。

すなわち、どれか1つが必ず起こること(結果がわかる時に)情報エントロピーは0になるということですね。

情報エントロピーの最大値は全てが等確率で起こる時

エントロピーの最大値は全ての事象が等確率で起こる時最大になります。

確かに、全てが等確率の時はどれが起こるか全く検討がつかないので複雑さは増しそうですね。

証明

\(H(X) =~ – \sum p(x_{i}) \log{p(x_{i})}\)を\( \sum p(x_{i}) = 1 \) の条件の元で最大化するので、Lagrangeの未定乗数法を用いて最大化すれば良いですね。

ラグランジュ関数を以下のように定義します。

$$ L \equiv H(X)~ – \lambda \sum p(x_{i}) $$

極値をとる条件より

ゆえに

$$ p(x_{i}) = \frac{1}{e} ~ 2^{ – \lambda} = const $$

他の\(p(x_{i}) \)についても同様なので、\( \sum p(x_{i}) = 1 \)より

\(H(X) \)を最大とする\(p(x_{i}) \)は\( p(x_{i}) = 1/n \)であることがわかります。

『Lagrangeの未定乗数法がよくわからない』という方は下記を参考にしてください

参考文献

参考文献は以下の2つです。

- 情報理論

- シャノンの情報理論入門

情報理論

見かけに寄らず、詳しく情報理論の内容を解説しています

シャノンの情報理論入門

情報理論の雰囲気を知るには最適な一冊です。

まとめ

情報量は、2つの要請のもと定式化できました。

- 確率が小さい時の方が情報量は大きい

- 情報は足し合わせできる

また、情報の不確定さを表す量も1つの要請から定式化することができました。

知っていることが少ない人ほど得られる情報の価値は大きくなる。

このような定式化をすることで情報をより理論的に扱いやすくなりました。

この定式化をすることによって深い理論と物理との関係が生まれてきます。

『Amazon Prime Student』は、大学生・大学院生限定のAmazon会員制度です。

Amazonを使用している方なら、必ず登録すべきサービスといっても過言ではありません…

主な理由は以下の通りです。

- 『Amazon Prime

』のサービスを年会費半額で利用可能

- 本が最大10%割引

- 文房具が最大20%割引

- 日用品が最大15%割引

- お急ぎ便・お届け日時指定便が使い放題

- 6ヶ月間無料で使用可能

特に専門書や問題集をたくさん買う予定の方にとって、購入価格のポイント10%還元はめちゃめちゃでかいです!

少なくとも私は、Amazon Prime Studentを大学3年生のときに知って、めちゃめちゃ後悔しました。

専門書をすでに100冊以上買っていたので、その10%が還元できたことを考えると泣きそうでした…ww

より詳しい内容と登録方法については下記を参考にしてください。

登録も退会もめちゃめちゃ簡単なので、6ヶ月の無料体験期間だけは経験してみても損はないと思います。